스터디 노트 (BeautifulSoup basic)

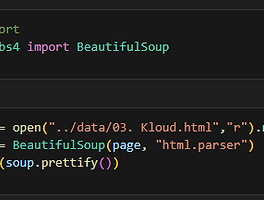

📌 BeautifulSoup - Basic 🚩 pip install beautifulsoup4 from bs4 import BeautifulSoup html 파일을 open 명령어로 선언, page 변수에 담아준다 BeautifulSoup에 page, "html. parser" 이용, html 파일을 읽는다 prettify() 함수를 이용하여 보기좋게 정리한다 🚩 Tag 확인 클래스를 지정하지 않을 시, 처음 발견된 태그만 출력 된다. 📌 find, find_all 함수 🚩 find 함수 find("tag_name", class_="class_name") find("tag_name", {"class":"class_name"}) 🚩 다중 조건 🚩 text, get_text(),string, strip() ..

스터디 노트 (BeautifulSoup basic)

📌 BeautifulSoup - Basic 🚩 pip install beautifulsoup4 from bs4 import BeautifulSoup html 파일을 open 명령어로 선언, page 변수에 담아준다 BeautifulSoup에 page, "html. parser" 이용, html 파일을 읽는다 prettify() 함수를 이용하여 보기좋게 정리한다 🚩 Tag 확인 클래스를 지정하지 않을 시, 처음 발견된 태그만 출력 된다. 📌 find, find_all 함수 🚩 find 함수 find("tag_name", class_="class_name") find("tag_name", {"class":"class_name"}) 🚩 다중 조건 🚩 text, get_text(),string, strip() ..